数据科学界最大的秘密是什么?AI 准确性在现实世界中毫无意义。

数据科学界最讳莫如深的真相是什么?

答案是:AI准确性在现实世界中毫无意义。本文将为用户体验设计师提供一个替代”准确性”的实用方案——一种以用户体验和商业价值为核心的优化方法,让AI学会用”人类价值观”思考。

准备好了吗?

惊天秘密

多年来,数据科学界一直依赖准确性(Accuracy)、精确率(Precision)和召回率(Recall)等指标运行。像Kaggle(https://www.kaggle.com/competitions)这类竞赛仅凭单一指标(如准确性)决出胜负。而鲜为人知的是:**这些指标虽具参考性,但对AI的实际应用价值微乎其微**。

举个汽车维修的案例

假设某虚构汽车品牌”帕斯卡汽车”在车辆中植入AI系统,用于发送定期保养警报。假设一辆车每年可能出现100个潜在问题,其中实际存在问题20个。若成功识别并预防一个问题可带来1000美元收益(例如通过预防性维修避免事故或中途抛锚),而调查一个潜在问题的成本为100美元(如技师一小时的检查费用)。

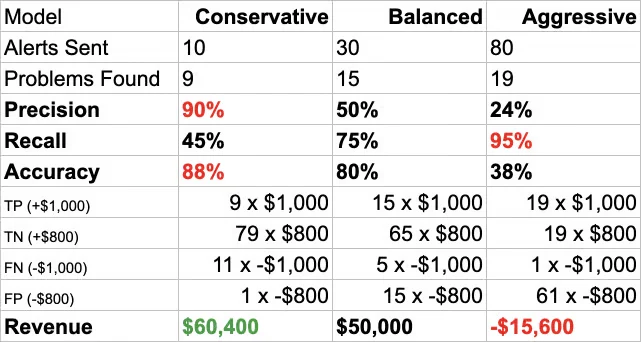

帕斯卡汽车的工程师有三种AI模型可选:保守型、平衡型和激进型。它们的性能指标如下:

表1:基于数据科学指标(准确性/精确率/召回率)的AI模型选择

您认为哪个模型最佳?

多数人会选择保守型AI——谁不想要既准确又精确的AI呢?

但请看现实结果:

表2:基于真实收益的AI模型选择(假设TP=1000美元,TN=100美元)

若仅凭数据科学指标选择,您的决策将完全错误。

当考虑正/负结果的真实成本并优先优化收益时,正确答案是平衡型AI(第二列)——其收益比保守型(高准确性AI)高出158%。

原因在于:

仅优化数据科学指标的AI,表现远逊于考量现实成本与收益的AI。

这就是数据科学界秘而不宣的真相。

高准确性AI为何会出错?

此刻您可能困惑:准确性高的AI怎么会出错?追求高准确性难道不是目标?要回答这个问题,我们需要拆解”准确性”的计算公式。请放心,过程会非常简洁——即使您对数学课充满阴影,也请继续阅读,我保证物超所值。

理解”准确性”的关键:混淆矩阵(Confusion Matrix)

这个名称唬人的工具其实非常简单——它通过统计模型预测结果与实际结果的对比,清晰呈现AI的表现。

(图片来源:Fortiche Studios via Midjourney | 风格描述:一位机器人正以神秘学风格认真检查汽车)

每当帕斯卡汽车的AI分析车辆的100个潜在问题时,它需决定是否发出警报。发出警报记为”阳性”(Positive),忽略传感器读数则为”阴性”(Negative)。假设每年有100次检测机会,AI共有100个决策点。

由于AI无法确知车辆是否存在问题(需依赖油液杂质、震动、异响等传感器数据),可能产生两类错误:

- 假阳性(False Positive):车辆正常时误发警报(例如冷启动异响被误判为故障)

- 假阴性(False Negative):存在严重隐患却未发出警报

因此,每次检测可能产生四种结果:

- 真阴性(TN):车辆正常,AI未发警报

- 假阴性(FN):存在故障,AI漏报

- 真阳性(TP):存在故障,AI正确报警

- 假阳性(FP):车辆正常,AI误报

混淆矩阵即统计各结果出现次数的工具。通过对比不同模型的结果分布,我们能直观评估其性能。

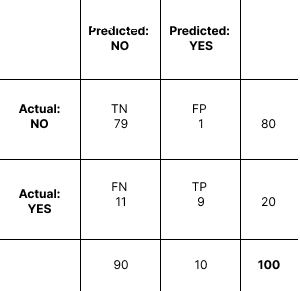

以保守型高准确性AI为例:

表3:保守型AI的混淆矩阵

解读方法:

- 总检测次数100次,实际存在问题20次(即80次正常)

- 保守型AI发出10次警报,90次判定”无问题”

- 在10次警报中,9次正确(TP),1次误报(FP)

计算准确性:

准确性 = 正确预测数 / 总预测数 × 100%

本例中:

正确预测 = 真阴性(79) + 真阳性(9) = 88

准确性 = 88/100 × 100% = 88%

88%的准确性看似优秀,但该模型漏报了20个问题中的11个!实际上,保守型AI连半数问题都未发现。

为何高准确性AI如此鸡肋?答案已呼之欲出:

追求准确性的AI往往过于保守——它竭力避免犯错,却因不敢及时报警而错失盈利机会。

反之,激进型AI(追求召回率)可能为找出19个问题发出80次警报,显然过度反应。

现实应用的最佳选择是平衡型AI:虽无突出数据指标,却能带来15,000美元的最高收益,比保守型高出158%。

在现实世界中,投资回报率(ROI)才是唯一重要的指标。

价值矩阵(Value Matrix):让AI为现实世界服务的工具

由Arijit Sengupta开发的价值矩阵,是对传统混淆矩阵的革命性改进。其核心在于:为每个预测结果赋予美元价值,从而直观计算AI模型的实际ROI。

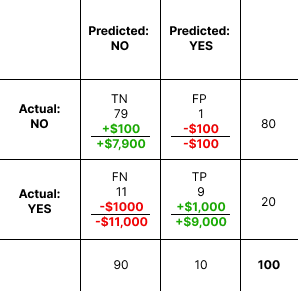

以保守型AI为例(假设TP=1000美元,TN=100美元):

表4:保守型AI的价值矩阵

解读规则:

- 正确预测产生收益(正数),错误预测造成损失(负数)

- 例如:误报(FP)导致100美元检查成本(-100),正确识别正常状态(TN)节省100美元(+100)

- 正确报警(TP)避免1000美元损失(+1000),漏报(FN)导致1000美元损失(-1000)

价值矩阵的精妙之处:

通过量化每个预测结果的经济影响,我们能精准评估不同AI模型的现实价值。更重要的是——价值假设的微小变化将彻底改变最优选择。

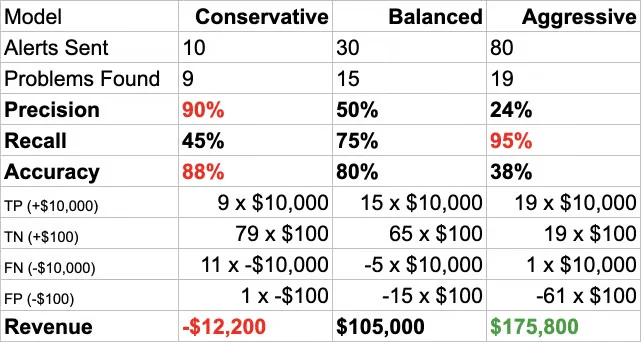

案例对比:

- 若误报成本升至800美元:保守型高准确性AI将是最优解

- 若正确报警收益升至10,000美元:激进型高召回率AI将胜出

甚至可能出现极端情况:当价值参数变化时,原本最优的模型可能产生负收益!例如当TP=10,000美元、TN=100美元时,部署保守型AI将亏损12,200美元,而其他模型却能创造10万+美元收益。

训练AI用”人类思维”思考现实后果

价值矩阵的启示显而易见:不同的价值假设将催生截然不同的最优方案。这正是用户体验设计的核心使命——通过深度理解使用场景,将人类价值融入AI训练。

一个震撼案例(来自Arijit Sengupta):

假设美国运输安全局(TSA)的AI用于预测旅客是否为恐怖分子。若该AI永远给出”否”(FALSE),其准确性将高达99.9999999999999999%(因绝大多数旅客无辜)。

这个超级准确的模型,同时也是彻底无用的废物。

但若考量以下价值:

- 恐怖袭击损失:1万亿美元

- 二次检查成本:每人1美元(按时薪30美元计算2分钟成本)

结果将颠覆认知——TSA即使对80亿全球人口进行125轮全员检查,仍能净赚1美元。这引出一个深刻问题:为何TSA不对所有旅客进行二次检查?

人类成本与收益的权衡

此刻,UX设计师的呐喊已响彻耳际:”那人类呢?客户的ROI怎么办?”

你们完全正确。除了商业成本,我们必须深入考量人性化代价。

这正是UX设计对AI解决方案至关重要的原因:

AI的未来绝不能只交给数据科学家。单纯的准确性、精确率等指标无法创造可行的现实方案。每个AI解决方案都必须深度理解其对商业和人类的影响。

作为UX设计师,您的使命是:确保这项革命性技术真正造福人类,并监督决策者为人类与星球的福祉负责。